Spis

Kogo dotyczy AI Act?

AI Act dotyczy wielu podmiotów, które korzystają ze sztucznej inteligencji, w tym:

- Dostawców algorytmów i technologii sztucznej inteligencji

- Użytkowników AI, a więc osoba fizyczna lub prawna, organ publiczny, agencja lub inny podmiot, który korzystają z AI. Wyjątkiem jest sytuacja, w której system sztucznej inteligencji jest wykorzystywany w ramach działalności pozazawodowej.

- Importerów i dystrybutorów

- Podmiotów spoza UE – jeśli ich systemy AI są stosowane na terenie Unii Europejskiej.

Rozporządzenie obejmuje również obowiązki związane z zarządzaniem ryzykiem. To jednak nie wszystko. AI Act ustala wymagania dotyczące przejrzystości i prowadzonej dokumentacji. Przepisy mogą dotyczyć systemów AI stosowanych w urządzeniach medycznych, maszynach czy samochodach.

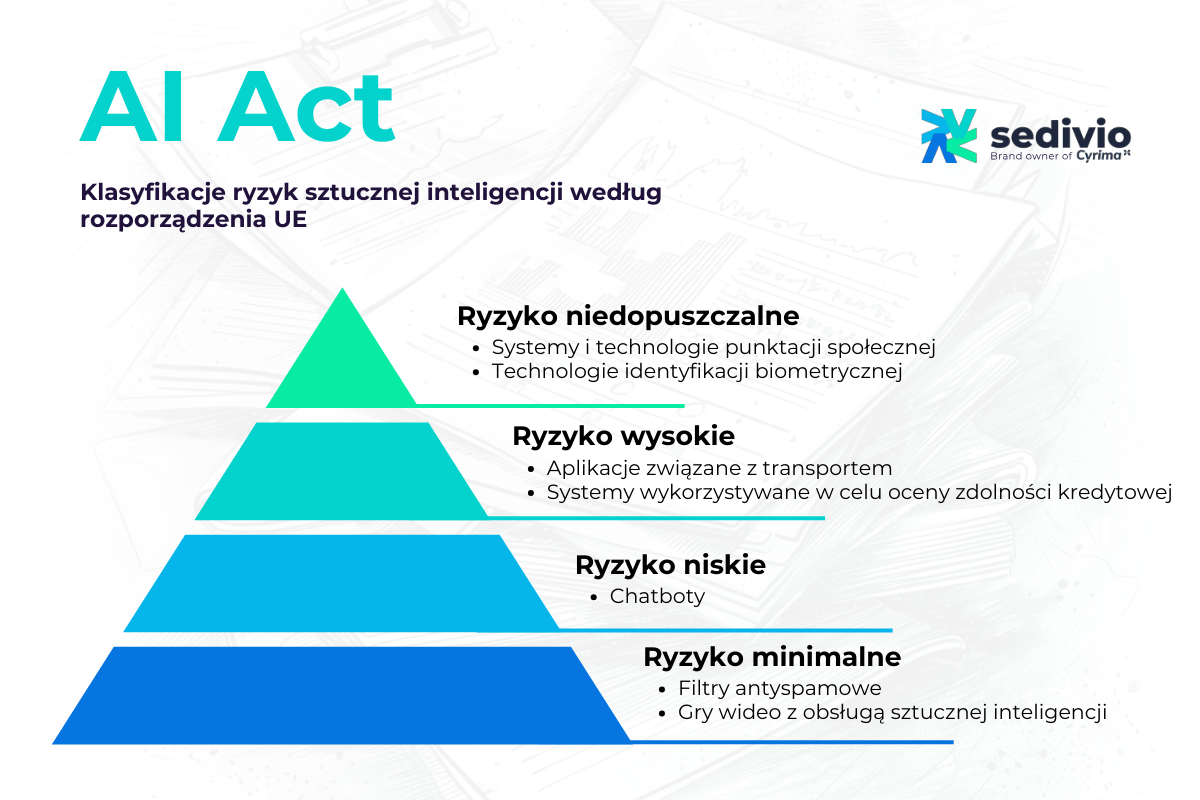

Rozporządzenie o sztucznej inteligencji przypisuje cztery kategorie ryzyka.

Ryzyko niedopuszczalne:

- Aplikacje obejmujące techniki podprogowe;

- Systemy i technologie punktacji społecznej;

- Systemy manipulacyjne, których celem lub skutkiem jest ograniczenie zdolności do podjęcia świadomej decyzji;

- Technologie kategoryzacji identyfikacji biometrycznej (z wyjątkami);

Wysokie ryzyko:

- Oprogramowanie związane z infrastrukturą krytyczną;

- Systemy używane przy rekrutacji;

- Systemy nadzoru pracowników;

- Systemy wykorzystywane w celu oceny zdolności kredytowej;

- Technologie wspomagające kontrolą graniczną;

- Systemy edukacyjne;

Przed wprowadzeniem systemu AI wysokiego ryzyka na rynek lub do użytku w UE, firmy muszą przeprowadzić uprzednią „ocenę zgodności”. Dodatkowo powinny spełnić długą listę wymagań, aby zapewnić, że ich technologia jest bezpieczna.

Ograniczone (niskie) ryzyko:

- Chatboty;

Minimalne ryzyko:

Aplikacje, które już teraz są szeroko wdrażane i stanowią większość systemów sztucznej inteligencji, z którymi obecnie wchodzimy w interakcje. Przykłady obejmują:

- Filtry antyspamowe;

- Gry wideo z obsługą sztucznej inteligencji;

AI Act – możliwe sankcje

AI Act przewiduje szereg sankcji za naruszenie wytycznych:

W przypadku naruszenia zakazanych praktyk grozi kara:

- do 35 000 000 euro

- albo do 7% całkowitego rocznego obrotu przedsiębiorstwa

W przypadku naruszenia pozostałych przepisów grozi kara:

- do 15 000 000 euro

- lub do 3% całkowitego rocznego obrotu przedsiębiorstwa

Za przekazywanie nieprawdziwych informacji grożą następujące kary:

- do 7 500 000 euro

- lub do 1% całkowitego rocznego obrotu przedsiębiorstwa

Globalne partnerstwo na rzecz sztucznej inteligencji (GPAI)

Globalne Partnerstwo na rzecz Sztucznej Inteligencji (GPAI) to inicjatywa, która wykorzystuje współpracę międzynarodową w zakresie kluczowych badań nad systemami i modelami związanymi ze sztuczną inteligencją.

Wszyscy dostawcy modeli GPAI muszą:

- sporządzać dokumentacje techniczną obejmującą przebieg szkoleń i testów;

- sporządzać dokumentację dla dostawców niższego szczebla, którzy zamierzają zintegrować model GPAI ze swoim własnym systemem sztucznej inteligencji;

- ustanowić politykę przestrzegania dyrektywy dotyczącej praw autorskich.

- opublikować szczegółowe podsumowanie treści używanych do szkolenia modelu GPAI.

Oprócz czterech powyższych obowiązków dostawcy modeli GPAI obarczeni ryzykiem systemowym muszą także:

- przeprowadzać oceny modeli w celu identyfikacji i ograniczania ryzyka;

- śledzić, dokumentować i zgłaszać incydenty oraz możliwe środki naprawcze do Biura ds. AI i właściwych organów krajowych.

- zapewnić odpowiedni poziom ochrony cyberbezpieczeństwa.

Sztuczna inteligencja a zarządzanie ryzykiem

Jak określić, w jaki sposób można skutecznie stosować ustawę o sztucznej inteligencji? Aby to zrobić, konieczne jest posiadanie ram zarządzania ryzykiem, które będą wspierać wytyczne AI Act. Nasza pomoc w zakresie cyberbezpieczeństwa i sztucznej inteligencji pomaga firmom opracować i wdrożyć takie działania. Oferujemy doradztwo, analizę ryzyk, a także projektowanie strategii bezpieczeństwa. Dzięki temu firmy mogą monitorować i minimalizować ryzyka, zapewniając zgodność z AI Act oraz ochronę danych przed zagrożeniami.

Kiedy AI Act wejdzie w życie?

Parlament przyjął ustawę o sztucznej inteligencji w marcu 2024 r., a Rada zatwierdziła ją w maju 2024 r. Ustawa zacznie obowiązywać w pełni 24 miesiące po wejściu w życie. Niektóre części będą miały zastosowanie wcześniej.:

– 6 miesięcy dla rozwiązań o niedopuszczalnym ryzyku.

– 12 miesięcy dla GPAI

– 24 lub 36 miesięcy dla rozwiązań o wysokim ryzyku (w zależności od ich charakteru)

AI Act będzie dotyczył organizacji w całej Unii Europejskiej. Organy państwowe, przedsiębiorcy i osoby fizyczne muszą przestrzegać jego postanowień od momentu wejścia w życie. Zalecamy już teraz sprawdzić, jak AI Act wpłynie na Twoją organizację.

Jak AI może wspierać Twój biznes?

Nasze usługi pomagają firmom efektywnie wdrażać sztuczną inteligencję w różnych obszarach:

- prowadzimy doradztwo w zakresie AI;

- za pomocą narzędzi AI oferujemy usługę analizy danych;

- tworzymy dedykowane systemy i aplikacje wykorzystujące moc generatywnej AI;

- integrujemy algorytmy AI z obecnie działającymi systemami i aplikacjami.

Doradzamy najlepsze kierunki działania w odpowiedzi na twoje cele biznesowe. Chcesz dowiedzieć się więcej? Zachęcamy do kontaktu w celu umówienia wstępnego spotkania.